Kubernetes dominiert die Container-Orchestrierung, weil es Bereitstellung, Skalierung und Wiederherstellung automatisiert und dabei unabhängig von der Cloud bleibt.

Wenn Sie die Grundkonzepte beherrschen, können Sie Anwendungen weltweit zuverlässig auf jeder Infrastruktur betreiben – ganz ohne ständiges Eingreifen.

Warum Kubernetes moderne Deployment-Probleme löst

Die meisten Teams setzen auf Container, um ihre Laufzeitumgebungen zu standardisieren. Allerdings wird das manuelle Verwalten vieler Container schnell zu einem fehleranfälligen Chaos.

Kubernetes beseitigt diese Reibung, indem Sie deklarieren können, wie sich eine Anwendung verhalten soll – zum Beispiel Anzahl der Replikate, Ressourcenbeschränkungen oder Netzwerkanbindung – und stellt diesen Zustand dann automatisch sicher, selbst bei Knoten-Ausfällen oder plötzlichen Lastspitzen.

Cluster-Architektur: Steuerungsebene und Arbeitsknoten

Ein klares mentales Modell des Clusters sorgt dafür, dass alle weiteren Details logisch nachvollziehbar bleiben.

Steuerebene

Die Steuerebene fungiert als Gehirn des Clusters. Vier integrierte Dienste koordinieren sämtliche Aktivitäten:

- API-Server: Der zentrale Einstiegspunkt für alle Aktionen, sei es durch Menschen oder automatisiert.

- etcd: Verteilter Key-Value-Store, der den gewünschten und den tatsächlichen Zustand speichert.

- Controller Manager: Hintergrundprozesse, die fehlgeschlagene Pods neu starten, neue Replikate erstellen oder Endpunkte aktualisieren.

- Scheduler: Intelligente Platzierungsinstanz, die ausstehende Pods je nach Ressourcenbelastung und Richtlinien passenden Nodes zuweist.

Hochverfügbare Installationen verteilen diese Komponenten auf mehrere Maschinen, um Hardwareausfälle zu überstehen.

Worker-Knoten

Worker-Knoten stellen CPU, Arbeitsspeicher und Netzwerkressourcen für Container bereit.

- kubelet steht in ständigem Kontakt mit der Steuerungsebene und startet oder stoppt Container entsprechend den Pod-Definitionen.

- Container-Runtime (Docker, containerd oder ähnlich) lädt Images herunter und startet Prozesse.

- kube-proxy konfiguriert die Netzwerkeinstellungen auf jedem Knoten, sodass Dienste ihre Ziel-Pods ohne manuelle Routingtabellen erreichen können.

Die Integrität der Datenebene hängt davon ab, dass auf jedem Knoten diese drei Agenten laufen.

Pods und Nodes: Die grundlegenden Einheiten

Ein Node entspricht einer Compute-Instanz; ein Pod besteht aus einem oder mehreren eng gekoppelten Containern, die sich dieselbe IP-Adresse, Volumes und Neustartrichtlinie teilen müssen.

Praktisches Pod-Beispiel

Ein kleiner Blog könnte NGINX und einen Anwendungs-Container in einem einzigen Pod bündeln. So ist eine lokale, latenzarme Kommunikation mit synchronisierten Lebenszyklen garantiert.

Fordern Sie drei Replikate an, plant Kubernetes drei identische Pods, die jeweils beide Container enthalten, auf den verfügbaren Knoten.

Warum die Pod-Abstraktion wichtig ist:

- Einheitliches Scheduling sorgt dafür, dass zusammengehörige Prozesse gemeinsam ausgeführt werden.

- Geteiltes Localhost-Netzwerk vermeidet externe Umwege.

- Atomare Skalierung ermöglicht horizontale Anpassungen mit einer einzigen Änderung der Replikat-Anzahl.

- Einzelner Gesundheitscheck vereinfacht Readiness- und Liveness-Prüfungen.

Netzwerkdienste und Ingress

Pods erhalten dynamische IP-Adressen, die sich ändern, wenn ein Pod neu geplant wird. Für einen stabilen Zugriff sind zusätzliche Abstraktionen erforderlich.

Dienste

Ein Dienst (Service) weist auf jedem Knoten eine virtuelle IP und optional einen Port zu. Es gibt vier gängige Muster:

- ClusterIP: Interner Zugriff innerhalb des Clusters.

- NodePort: Hoher Port auf jedem Knoten zur direkten Nutzung während der Entwicklung.

- LoadBalancer: Von der Cloud bereitgestellter externer Endpunkt für Produktionsdatenverkehr.

- ExternalName: DNS-Alias, der Anfragen außerhalb des Clusters weiterleitet.

Label-Selektoren verbinden den Dienst mit den zugehörigen Backend-Pods, sodass sich bei Skalierung der Anwendung die Verbindungspunkte automatisch aktualisieren.

Ingress

Ingress bietet HTTP-bewusstes Routing, pfadbasierte Regeln und TLS-Termination. Anstatt für jeden Service einen eigenen Port zu öffnen, definieren Sie Host- und Pfadregeln, die den Datenverkehr an den richtigen Service weiterleiten. So bündeln Sie die externe Erreichbarkeit hinter einem einzigen Load Balancer.

Laufzeitkonfiguration: ConfigMaps und Secrets

Das Festschreiben von Werten in Images schränkt die Flexibilität ein und erhöht das Risiko von Datenlecks. Kubernetes bietet zwei Ressourcentypen, um Einstellungen auszulagern.

- ConfigMap – speichert nicht-sensitive Daten wie Umgebungsnamen, Feature-Flags oder API-Endpunkte. Container können darauf als Umgebungsvariablen oder eingehängte Dateien zugreifen.

- Secret – enthält sensible Werte wie API-Schlüssel oder TLS-Zertifikate. Secrets werden base64-codiert und können vom Schlüsselverwaltungssystem des Anbieters im Ruhezustand verschlüsselt werden.

Das Aktualisieren eines dieser Objekte löst einen Rolling-Reload aus, sodass sich Konfigurationen anpassen lassen, ohne die Container neu bauen zu müssen.

Datenpersistenz mit Volumes

Zustandslose Dienste können problemlos neu gestartet werden, aber Datenbanken benötigen dauerhaften Speicher. Kubernetes trennt Daten von Pods durch den Einsatz von Volumes.

- PersistentVolume (PV) steht für den tatsächlichen Speicher, zum Beispiel eine lokale Festplatte, ein Netzlaufwerk oder einen Blockspeicher in der Cloud.

- PersistentVolumeClaim (PVC) ist eine Anforderung für eine bestimmte Speicherkapazität und einen bestimmten Zugriffsmodus.

Ein Pod bindet das PVC an einen Pfad ein, sodass die Daten Neustarts oder Verschiebungen des Containers überstehen.

Dieses Modell unterstützt Cluster über mehrere Zonen hinweg, da Volumes – sofern die StorageClass es zulässt – beim Wechsel des Pods auf einen anderen Knoten neu angebunden werden.

Workload-Controller

Controller bieten erweiterte Orchestrierungsfunktionen, indem sie den tatsächlichen Zustand kontinuierlich dem gewünschten Ziel annähern.

Bereitstellungen

Bereitstellungen eignen sich für zustandslose Dienste. Sie halten eine festgelegte Anzahl von Replikaten aufrecht, unterstützen unterbrechungsfreie Rolling-Updates und ermöglichen sofortige Rollbacks, falls ein Release fehlschlägt.

StatefulSets

StatefulSets verwalten Workloads, die stabile Netzwerkidentitäten und eigene Speicher benötigen, wie zum Beispiel Datenbanken oder Message Queues. Die Pods erhalten fortlaufende Namen und jeweils ein eigenes PVC, was einen geordneten Start- und Herunterfahrprozess ermöglicht.

Jobs und CronJobs

Jobs erstellen Pods, die so lange laufen, bis sie erfolgreich abgeschlossen sind, und fehlgeschlagene Durchläufe automatisch erneut versuchen. CronJobs planen Jobs in cron-basierten Intervallen, zum Beispiel für nächtliche Backups.

DaemonSets

DaemonSets stellen sicher, dass auf jedem Knoten eine Instanz eines Pods läuft. Sie werden häufig für Log-Shipper oder Monitoring-Agenten verwendet, die zusammen mit allen Anwendungs-Workloads ausgeführt werden müssen.

Deklarative Manifeste ohne Ballast

Jedes Kubernetes-Objekt – egal ob Deployment, Service, ConfigMap oder Secret – verwendet ein YAML-Manifest, um die gewünschte Konfiguration zu beschreiben. Ein Manifest benötigt mindestens:

- apiVersion – legt die Schema-Version fest.

- kind – gibt den Objekttyp an.

- metadata – enthält den Objektnamen und optionale Labels.

- spec – definiert den Soll-Zustand, zum Beispiel Container-Image, Ports, Replikatanzahl oder Selektoren.

Manifeste in der Versionskontrolle zu bündeln schafft eine nachvollziehbare Historie und unterstützt automatisierte Pipelines. Sie lassen sich in jedem Cluster weltweit anwenden, und Kubernetes stellt ohne manuelles Skripten den gewünschten Zustand automatisch her.

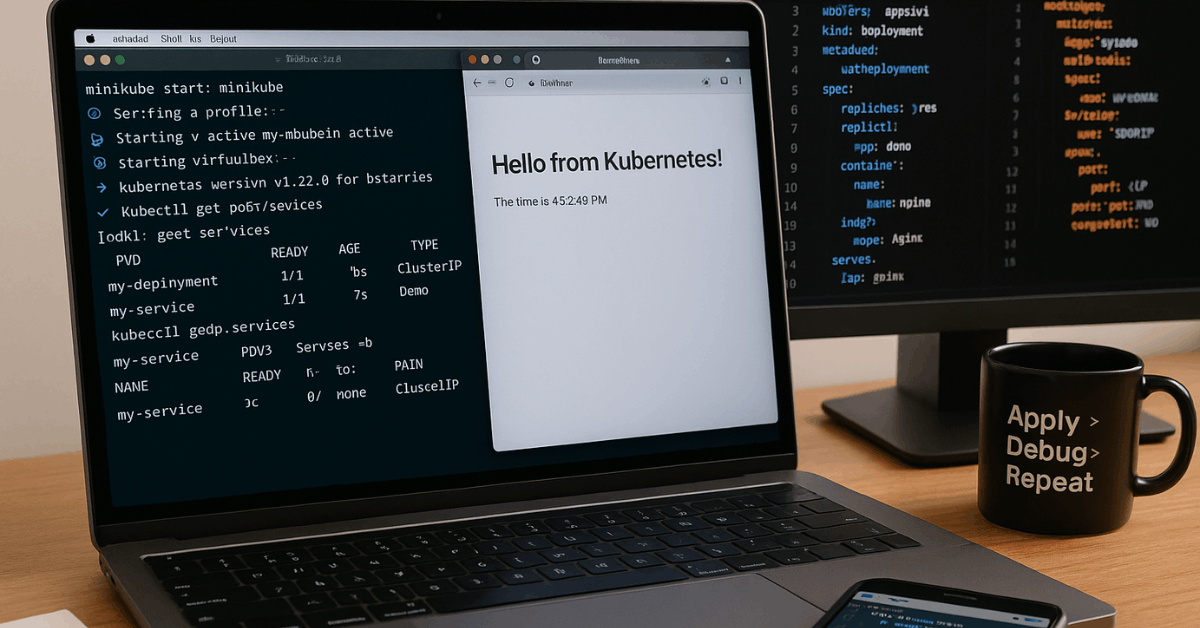

Lokale Sandbox-Einrichtung mit Minikube oder K3s

Kubernetes lokal auszuführen, beschleunigt das Lernen und das Erstellen von Prototypen.

- Installieren Sie einen Hypervisor, der mit Ihrem Betriebssystem kompatibel ist.

- Laden Sie Minikube herunter oder installieren Sie K3s über das offizielle Skript.

- Starten Sie den Cluster – jedes Tool stellt eine Single-Node-Umgebung bereit, die sowohl die Control Plane als auch die Worker-Rolle umfasst.

- Überprüfen Sie die Einsatzbereitschaft, indem Sie die Nodes auflisten und sicherstellen, dass der Status Ready lautet.

- Deployen Sie eine Beispielanwendung, um Scheduling, Netzwerk und Skalierung zu testen.

Der gesamte Ablauf ist auf modernen Laptops in wenigen Minuten abgeschlossen, sodass Sie ohne Cloud-Kosten experimentieren können.

Wichtige Cluster-Interaktionen

kubectl bleibt die universelle Kommandozeilenschnittstelle. Häufige tägliche Aktionen umfassen:

- Abfragen von Informationen über Cluster und Knoten.

- Auflisten von Ressourcen innerhalb oder über Namespaces hinweg.

- Beschreiben einzelner Objekte, um Status und Ereignisse zu überprüfen.

- Hoch- oder Herunterskalieren von Deployments entsprechend der Auslastung.

- Auslesen von Pod-Logs zur Fehlerbehebung.

- Interaktive Shells innerhalb von Containern für schnelle Diagnosen ausführen.

- Weiterleiten lokaler Ports zu internen Services während der Entwicklung.

- Ressourcen sauber löschen, um Kapazitäten freizugeben.

Wer diese Interaktionen beherrscht, erhält schnelle Rückmeldungen und gezielte Kontrolle über die Umgebung – weltweit.

Erweiterung von Kubernetes für Team-Workflows

Größere Organisationen integrieren GitOps-Plattformen, Policy-Engines und eigene Controller.

- GitOps-Pipelines synchronisieren Manifest-Repositorien mit Clustern und erstellen Vorschau-Reports, bevor Änderungen übernommen werden.

- Policy-Frameworks erzwingen Namenskonventionen, Sicherheitsstandards und Ressourcenquoten.

- Custom Resource Definitions (CRDs) modellieren domänenspezifische Objekte, während zugehörige Controller wiederkehrende Aufgaben wie die Bereitstellung von Datenbanken oder die Rotation von Zertifikaten automatisieren.

Diese Erweiterungen nutzen das gleiche Reconciliation-Muster, das in Kubernetes eingebaut ist, und gewährleisten so Konsistenz und Nachvollziehbarkeit über alle Umgebungen hinweg.

Fazit und Ihre nächsten praktischen Schritte

Richten Sie einen lokalen Cluster ein und stellen Sie einen einfachen Webdienst sowie eine Datenbank mithilfe von Deployments und StatefulSets bereit. Fügen Sie ein ConfigMap für nicht geheime Einstellungen und ein Secret für Zugangsdaten hinzu. Beobachten Sie anschließend, wie Rolling Updates Änderungen ohne Ausfallzeiten übernehmen.

Binden Sie ein PVC an das Datenbank-Pod an, simulieren Sie einen Knotenausfall und prüfen Sie, ob die Daten nach dem erneuten Scheduling erhalten bleiben. Skalieren Sie das Web-Deployment, überwachen Sie die Ressourcennutzung und fügen Sie eine Ingress-Regel für einen reibungslosen externen Zugriff hinzu.

Committen Sie alle Manifeste in die Versionsverwaltung und probieren Sie anschließend ein GitOps-Tool aus, um künftige Aktualisierungen automatisch zu synchronisieren. Die praktische Arbeit mit diesen Szenarien festigt das theoretische Wissen und hilft Ihnen, die notwendige Routine zu entwickeln, um Kubernetes in jeder Größenordnung sicher in der Produktion zu betreiben.